みなさん、こんにちは!業務ハックLabのようです。

前回の記事では、Azure OpenAI ServiceとChatGPTの違いについて整理しました。

セキュリティ面でのメリットとか、企業が選ぶ理由とか、理論的な話は一通りお伝えしたんですが…

(で、結局どうやって使うの?って思いましたよね!)

今回は、プログラミング一切なしでAzure OpenAIを実際に触っていきます!

Azure AI Foundry Playground、使ってますか?

皆さん、Azure OpenAIに興味はあるけど、どこから手をつければいいか迷っていませんか?

「API?SDK?難しそう…」って思った方、安心してください!

Azure AI Foundry Playgroundを使えば、ブラウザだけでAzure OpenAIを体験できるんです。

(コード書かなくていいって最高ですよね!)

今回は、リソース作成からPlaygroundでの実践まで、画面キャプチャ付きで丁寧に解説していきます。

この記事のゴール:

- Azure OpenAIリソースを作成できる

- Chat Playgroundで実際にAIと会話できる

- System Messageでカスタマイズできる

- パラメーター調整で出力を制御できる

- よくあるエラーに対処できる

では、早速始めていきましょう!

事前準備:必要なもの

まずは、必要なものを確認しますね。

必須要件:

- Azureアカウント

- アクティブなサブスクリプション(Pay-as-you-go / MSDN / Enterprise Agreement)

- Webブラウザ(Chrome / Edge推奨)

⚠️ 重要な注意事項:

無料トライアルやAzure Passでは、Azure OpenAIのQuotaが0 TPMのため、一切使用できません。

Azure OpenAIを使用するには、以下のいずれかの有料サブスクリプションが必要です:

- Pay-as-you-go(従量課金)サブスクリプション

- MSDNサブスクリプション

- Enterprise Agreement

無料トライアルをお持ちの方は、従量課金へのアップグレードが必要です。

(無料では試せないのが残念ですが、これがAzure OpenAIの仕様なんですよね…)

必要な権限:

- サブスクリプションまたはリソースグループに対する「共同作成者」以上の権限

- Azure OpenAIリソースを作成する権限

(既にAzure使ってる方なら、大抵の場合は大丈夫です!)

所要時間: 約30分

それでは、実際にやっていきましょう!

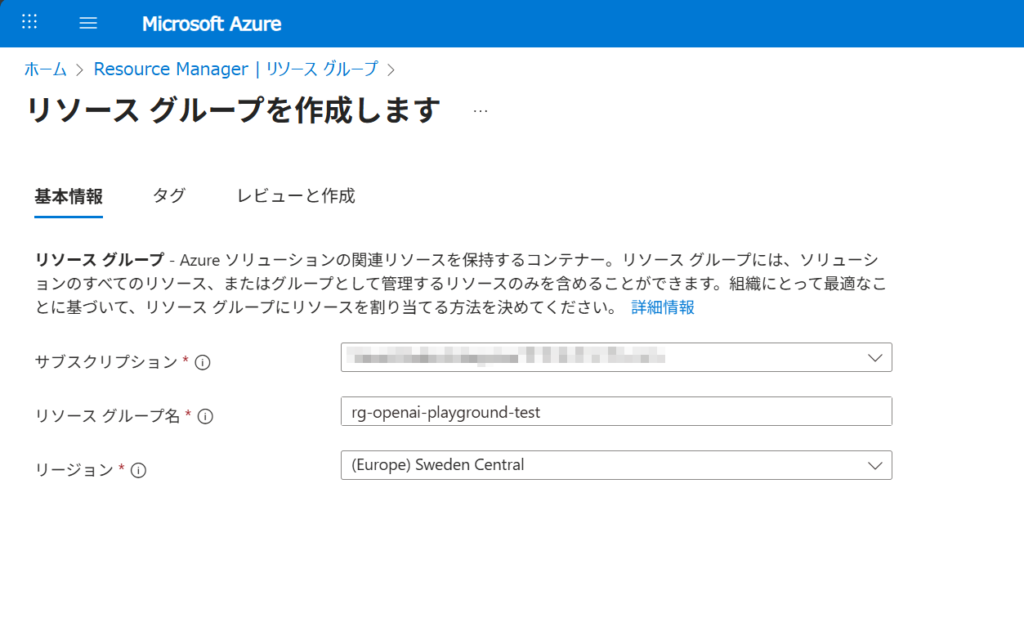

Step 1: リソースグループを作成する

はい、まずはリソースグループから作っていきます。

(Azureでは、関連するリソースをグループで管理するんですよね)

手順

- Azure Portalにアクセス

- 左側メニューまたは検索バーから「リソースグループ」を選択

- 「+ 作成」をクリック

- 以下を入力します:

- サブスクリプション: 使用するサブスクリプションを選択

- リソースグループ名:

rg-openai-playground-test

(好きな名前でOKですが、後で分かりやすい名前がおすすめです!) - リージョン: East US または Sweden Central

(Azure OpenAIの可用性が高いリージョンです)

- 「確認および作成」→「作成」

数秒で作成が完了します。

簡単ですね!

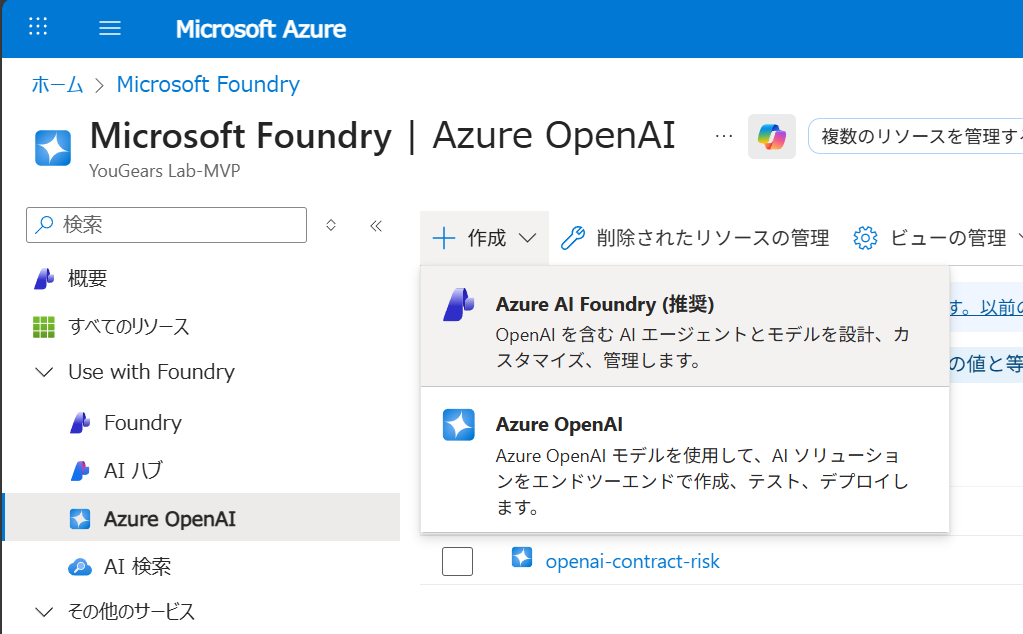

Step 2: Azure OpenAIリソースを作成する

次は、いよいよAzure OpenAIのリソースを作っていきます!

手順

- Azureポータルの上部検索バーで「Azure OpenAI」と入力

- 検索結果から「Azure OpenAI」を選択

自動的にMicrosoft Foundryポータルに遷移します。

- Microsoft Foundryポータルが開いたら、画面右側に表示されている「Azure OpenAI」カードをクリック

⚠️ 注意: 「Azure AI Foundry(推奨)」ではなく、「Azure OpenAI」の方を選んでくださいね!

- リソース作成画面が表示されます

- 基本(Basics) タブで以下を入力:

- サブスクリプション: 先ほどと同じものを選択

- リソースグループ:

rg-openai-playground-test(Step 1で作成したもの) - リージョン: リソースグループと同じリージョン

- 名前:

openai-playground-test-001

(グローバルで一意である必要があります。既に使われている場合は数字を変えてください!) - 価格レベル: Standard S0

- 「次へ: ネットワーク」をクリック

- ネットワーク タブ:

- ネットワークの種類: 「すべてのネットワーク(インターネットを含む)」

(実験なので広く開放します。本番環境では要検討です!)

- ネットワークの種類: 「すべてのネットワーク(インターネットを含む)」

- 「次へ: タグ」→ スキップしてOK

- 「確認および作成」→ 内容を確認 → 「作成」

- デプロイ完了を待ちます(通常1-2分)

よくあるエラーと対処法

ここで、いくつかエラーに遭遇する可能性があります。

エラー1: 名前が既に使用されている

The resource name is already in use原因: Azure OpenAIのリソース名はグローバルで一意である必要があります。

解決策: 名前に日付や数字を追加してください。

例: openai-playground-test-20260106

エラー2: リージョンで利用不可

Azure OpenAI is not available in the selected region原因: 選択したリージョンでAzure OpenAIが提供されていません。

解決策: 以下のリージョンを試してください:

- East US

- East US 2

- Sweden Central

- West Europe

- France Central

(リージョンによって提供状況が違うんですよね…)

はい、リソースの作成が完了しました!

次は、実際にPlaygroundを開いていきます。

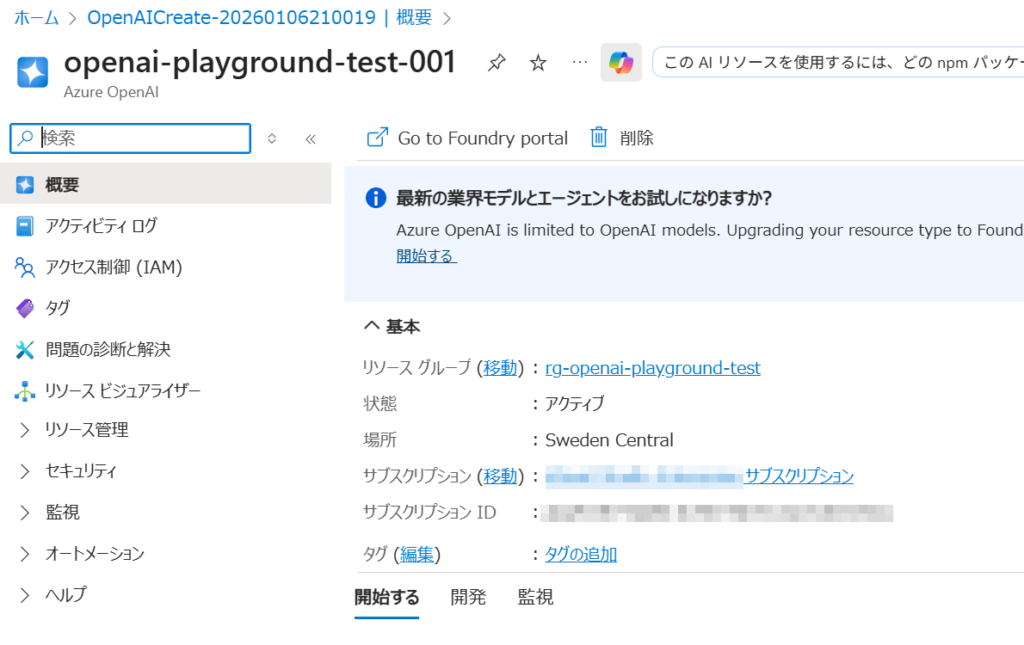

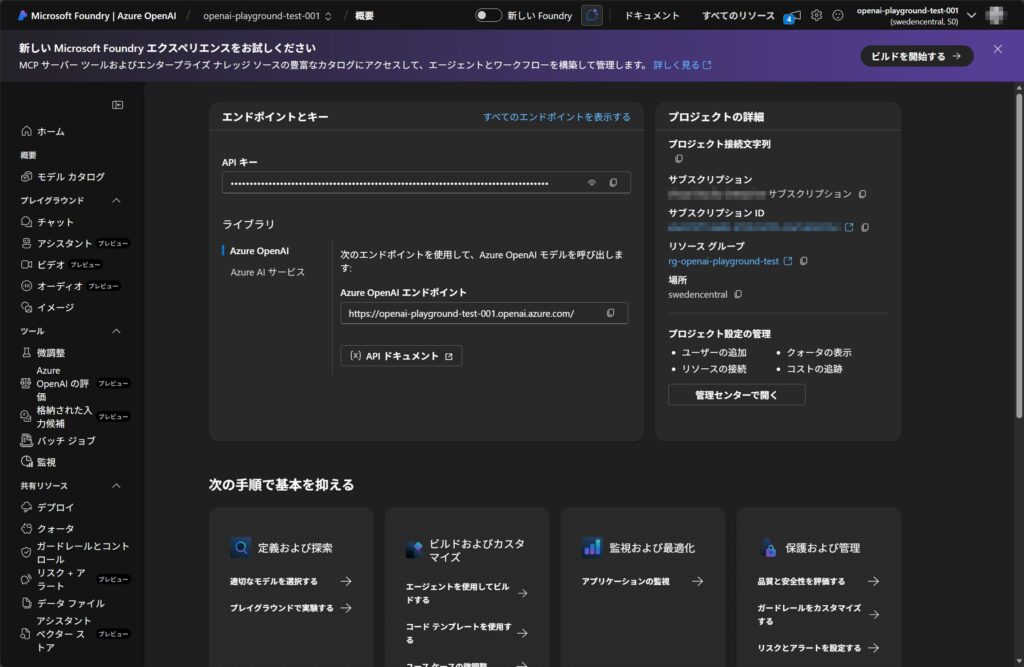

Step 3: Microsoft Foundry Studioへ移動する

デプロイが完了したら、Playgroundにアクセスしていきましょう。

手順

- デプロイ完了画面で「リソースに移動」をクリック

- Azure OpenAIリソースの概要画面が表示されます

- 画面中央または上部メニューに「Go to Foundry portal」というボタンがあるのでクリック

- 新しいタブでMicrosoft Foundry Studioが開きます

確認ポイント

画面左上で、正しいリソースが選択されているか確認してください。

左側メニューに「デプロイ」などの項目が見えていればOKです!

(Foundryの新UIだと「Models + endpoints」と表示される場合もあります)

Step 4: モデルをデプロイする

はい、ここからが本番です!

実際にAIモデルをデプロイしていきます。

モデル選択について

今回はgpt-4o-miniを使います。

理由は:

- ✅ 応答が速い(初回5秒、2回目以降3秒程度)

- ✅ Quotaが緩い(100K TPM)

- ✅ コストが低い

- ✅ 基本的な実験には十分な性能

(gpt-5.2とか最新モデルもありますが、初心者はまずgpt-4o-miniで慣れるのがおすすめです!)

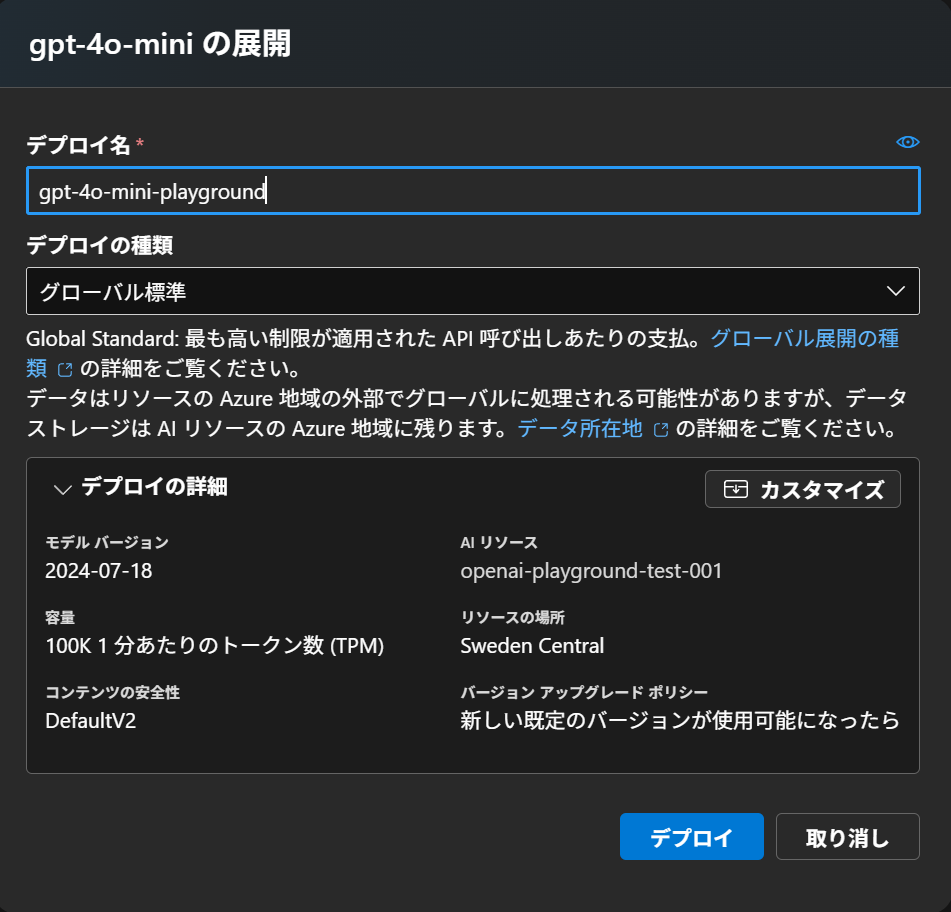

手順

- 左側メニューから「デプロイ」を選択

- 「+ デプロイの作成」→「基本モデルのデプロイ」

- モデル一覧から「gpt-4o-mini」を検索して選択

- デプロイ設定:

- Deployment name:

gpt-4o-mini-playground

(後でコードから呼び出す時に使う名前です) - Deployment type: グローバル標準(Global Standard)

(最新のUIだとこれが推奨されています) - Model version: 最新版(デフォルトでOK)

- Tokens per Minute Rate Limit: デフォルトのまま

- Deployment name:

- 「デプロイ」をクリック

- デプロイ完了を待ちます(通常1-3分)

- ステータスが「成功」または「Succeeded」になることを確認

Quotaについて

もし「Quota超過」エラーが出た場合:

原因: サブスクリプションタイプによってデフォルトQuotaが異なります。

| サブスクリプション | gpt-4o-mini Quota |

|---|---|

| Pay-as-you-go | 200K TPM |

| MSDN | 200K TPM |

| Azure for Students | 1K TPM(ほぼ使えない) |

| 無料トライアル/Azure Pass | 0 TPM(使用不可) |

解決策:

無料トライアル/Azure Passの場合:

- 従量課金サブスクリプションにアップグレード

- MSDNサブスクリプションを使用

(無料では使えないので、最低でもPay-as-you-goが必要です…)

Pay-as-you-go/MSDNでQuota不足の場合:

- 別のリージョンを試す(リージョンごとに独立したQuotaプールがあります)

- Quota増加申請フォームから申請

(Quota問題はAzure OpenAI初心者の最大の壁ですね…)

はい、デプロイが完了しました!

次は、いよいよChat Playgroundを開きます。

Step 5: Chat Playgroundを開く

デプロイしたモデルを使って、実際に会話してみましょう!

手順

- デプロイ一覧で「gpt-4o-mini-playground」の行をクリック

- 「プレイグラウンドで開く」または「Open in playground」をクリック

- 「チャット プレイグラウンド」を選択

- Chat Playgroundが開きます

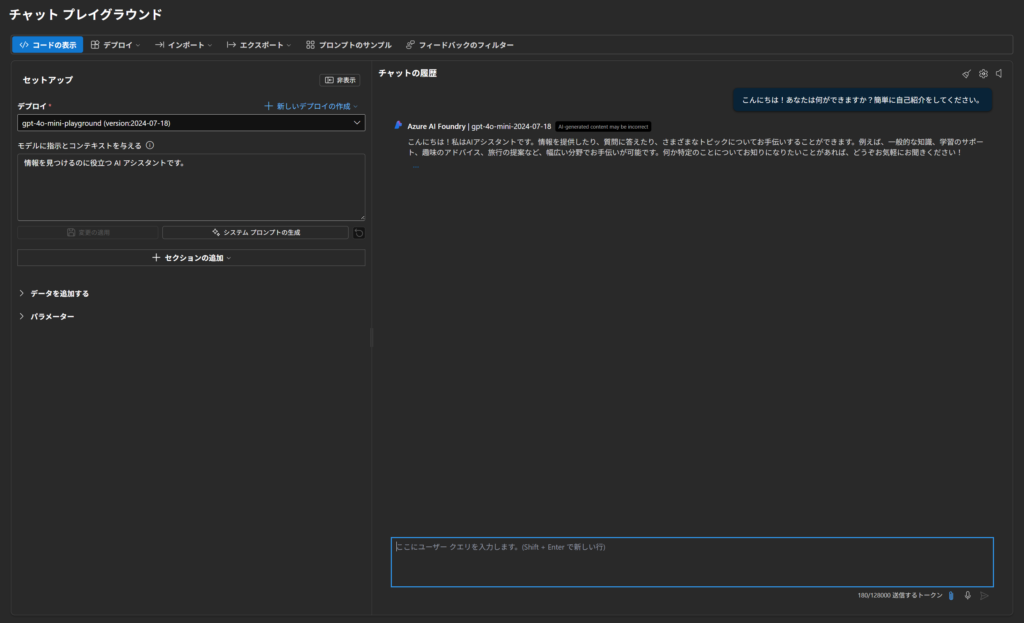

画面構成の確認

Chat Playgroundは2パネル構成になっています。

左側パネル(セットアップ):

- デプロイの選択

- System message(モデルに指示とコンテキストを与える)

- パラメーター設定(Temperature、Max tokensなど)

右側パネル(チャットの履歴):

- 実際の会話エリア

- メッセージの入力欄

(シンプルで分かりやすいレイアウトですね!)

Step 6: 初めての会話をしてみる

それでは、実際にAIと会話してみましょう!

まずはデフォルト状態で試してみます。

(System messageもParametersも、何も設定しない状態です)

手順

- 右側のチャット入力欄に以下を入力:

こんにちは!あなたは何ができますか?簡単に自己紹介をしてください。- Enterキーを押す、または送信ボタンをクリック

- 応答を待ちます

結果

こんな感じで返ってきました:

こんにちは!私はAIアシスタントです。情報を提供したり、質問に答えたり、さまざまなトピックについてお手伝いすることができます。例えば、一般的な知識、学習のサポート、趣味のアドバイス、旅行の提案など、幅広い分野でお手伝いが可能です。何か特定のことについてお知りになりたいことがあれば、どうぞお気軽にお聞きください!

所要時間:

- 初回応答: 約5秒

- 2回目応答: 約3秒

初回は少し時間がかかりますが、これは正常です。

(デプロイ直後の初期化処理なんですよね。2回目以降は高速化します!)

はい、これで基本的な会話ができることを確認できました!

次は、System Messageを使ってAIの振る舞いをカスタマイズしていきます。

System Messageを使いこなす

ここからが面白いところです!

System Messageを使うと、AIの「性格」や「役割」を自由に設定できるんです。

System Messageとは?

System Messageは、AIの「説明書」みたいなものです。

例えば:

- 「あなたは親切なカスタマーサポート担当です」

- 「あなたは厳格な文法チェッカーです」

- 「あなたは技術文書を要約する専門家です」

こういう指示を与えることで、AIの応答スタイルを変えられます。

(これ、めちゃくちゃ便利なんですよ!)

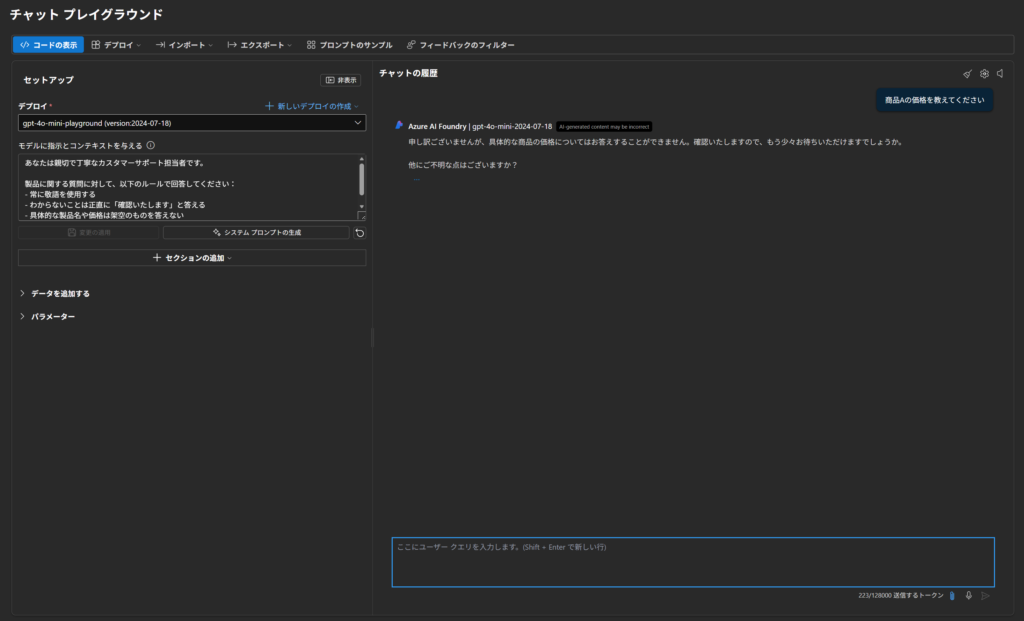

実験1: カスタマーサポートBot

では、実際に試してみましょう。

手順

- 左側パネルの「モデルに指示とコンテキストを与える」欄に以下を入力:

あなたは親切で丁寧なカスタマーサポート担当者です。

製品に関する質問に対して、以下のルールで回答してください:

- 常に敬語を使用する

- わからないことは正直に「確認いたします」と答える

- 具体的な製品名や価格は架空のものを答えない

- 最後に「他にご不明な点はございますか?」と聞く- 「システム プロンプトの生成」ボタンの横にある「変更の適用」をクリック

(確認ダイアログが出たら「続行」を選んでください)

- 右上の「チャットをクリア」をクリック

(前の会話の影響を避けるため、必ずクリアしてくださいね!)

- 以下の質問を入力:

商品Aの価格を教えてください結果

こう返ってきました:

申し訳ございませんが、具体的な商品の価格についてはお答えすることができません。確認いたしますので、もう少々お待ちいただけますでしょうか。

他にご不明な点はございますか?

評価:

- ✅ 敬語を使用している

- ✅ 「他にご不明な点は」と聞いている

- ✅ 架空の価格を答えていない

- ✅ 全体的にカスタマーサポートらしい

完璧ですね!

System Messageの指示通りに動作しています。

(これ、実際の業務でも使えそうですよね!)

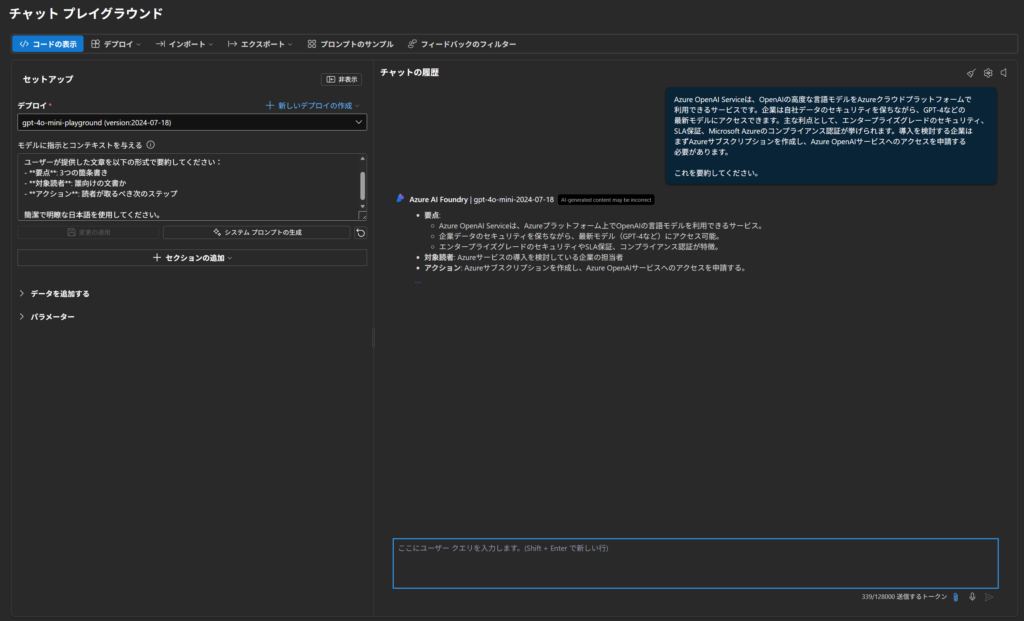

実験2: 技術文書の要約Bot

次は、別のパターンを試してみましょう。

手順

- System messageを以下に変更:

あなたは技術文書を要約する専門家です。

ユーザーが提供した文章を以下の形式で要約してください:

- **要点**: 3つの箇条書き

- **対象読者**: 誰向けの文書か

- **アクション**: 読者が取るべき次のステップ

簡潔で明瞭な日本語を使用してください。- 変更を適用 → チャットをクリア

- 以下のテキストを貼り付け:

Azure OpenAI Serviceは、OpenAIの高度な言語モデルをAzureクラウドプラットフォームで

利用できるサービスです。企業は自社データのセキュリティを保ちながら、GPT-4などの

最新モデルにアクセスできます。主な利点として、エンタープライズグレードのセキュリティ、

SLA保証、Microsoft Azureのコンプライアンス認証が挙げられます。導入を検討する企業は

まずAzureサブスクリプションを作成し、Azure OpenAIサービスへのアクセスを申請する

必要があります。

これを要約してください。結果

こう返ってきました:

要点:

Azure OpenAI Serviceは、Azureプラットフォーム上でOpenAIの言語モデルを利用できるサービス。

企業データのセキュリティを保ちながら、最新モデル(GPT-4など)にアクセス可能。

エンタープライズグレードのセキュリティやSLA保証、コンプライアンス認証が特徴。

対象読者: Azureサービスの導入を検討している企業の担当者アクション: Azureサブスクリプションを作成し、Azure OpenAIサービスへのアクセスを申請する。

評価:

- ✅ 指定したフォーマット(要点・対象読者・アクション)になっている

- ✅ 要点が3つの箇条書きになっている

- ✅ 簡潔で明瞭

これも完璧です!

System Messageで出力フォーマットまで制御できるんです。

(議事録の要約とか、レポート作成とか、実務で超使えますね!)

System Messageのベストプラクティス

実験を通じて分かったポイントをまとめます。

良いSystem Messageの書き方:

- ✅ 明確な言葉を使う – 曖昧な表現は避ける

- ✅ 簡潔に – 長すぎると逆効果

- ✅ 一人称で書く – 「あなたは〜です」形式

- ✅ 具体的な例を示す – 「〜のように」と例示する

避けるべきこと:

- ❌ 曖昧な指示(「良い感じに」「適当に」など)

- ❌ 矛盾する指示

- ❌ 長すぎる説明

(公式ドキュメントにもベストプラクティスが載っているので、興味がある方はこちらをチェックしてみてください!)

パラメーター調整で出力をコントロールする

はい、次はパラメーターを触っていきましょう!

左側パネルの「パラメーター」セクションを開くと、いろいろな設定項目が出てきます。

(最初は折りたたまれているので、クリックして展開してくださいね)

パラメーター一覧

主なパラメーターはこちら:

- 過去のメッセージを含む: 会話履歴をどれだけ参照するか(デフォルト: 10)

- 最大応答: 応答の最大トークン数(デフォルト: 数千)

- 温度(Temperature): ランダム性の制御(0〜1)

- 上位 P(Top P): トークン選択の多様性(0〜1)

- シーケンスの停止: 応答を止めるキーワード

- 頻度のペナルティ: 繰り返しを減らす(-2.0〜2.0)

- プレゼンスのペナルティ: 新しい話題を促す(-2.0〜2.0)

今回は、特に重要なTemperatureと最大応答を実験してみます。

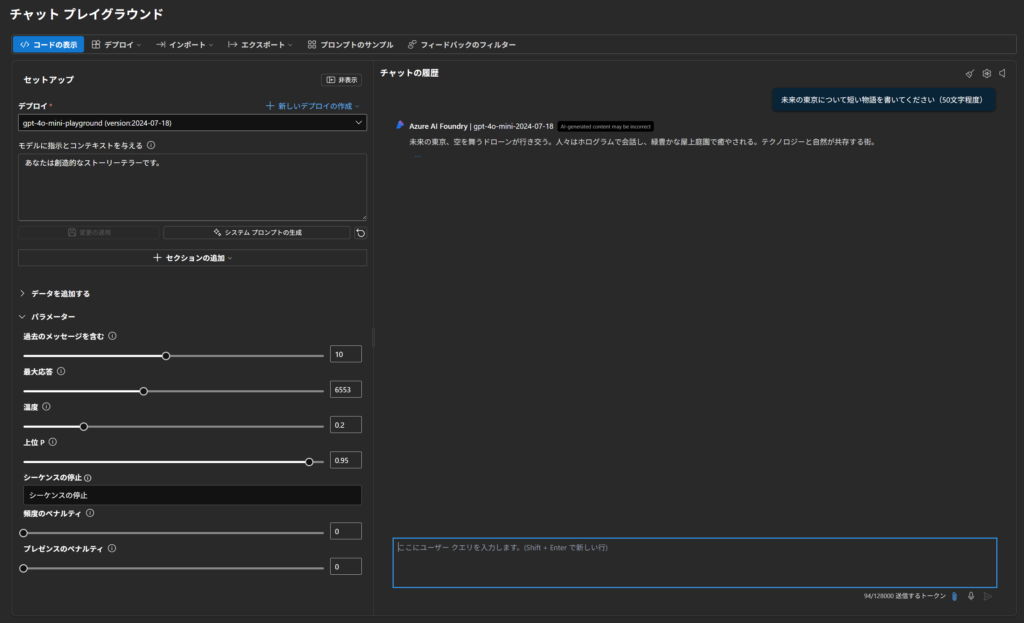

実験3: Temperature(温度)の比較

Temperatureはランダム性を制御するパラメーターです。

- 低い値(0.2など): 安定的・予測可能な回答

- 高い値(1.0など): 創造的・予測不可能な回答

では、実際に比較してみましょう!

手順

- System message:

あなたは創造的なストーリーテラーです。- 変更を適用 → チャットをクリア

- 「パラメーター」セクションで「温度」を 0.2 に設定

- 以下の質問を入力:

未来の東京について短い物語を書いてください(50文字程度)- 返答をメモ

- チャットをクリア

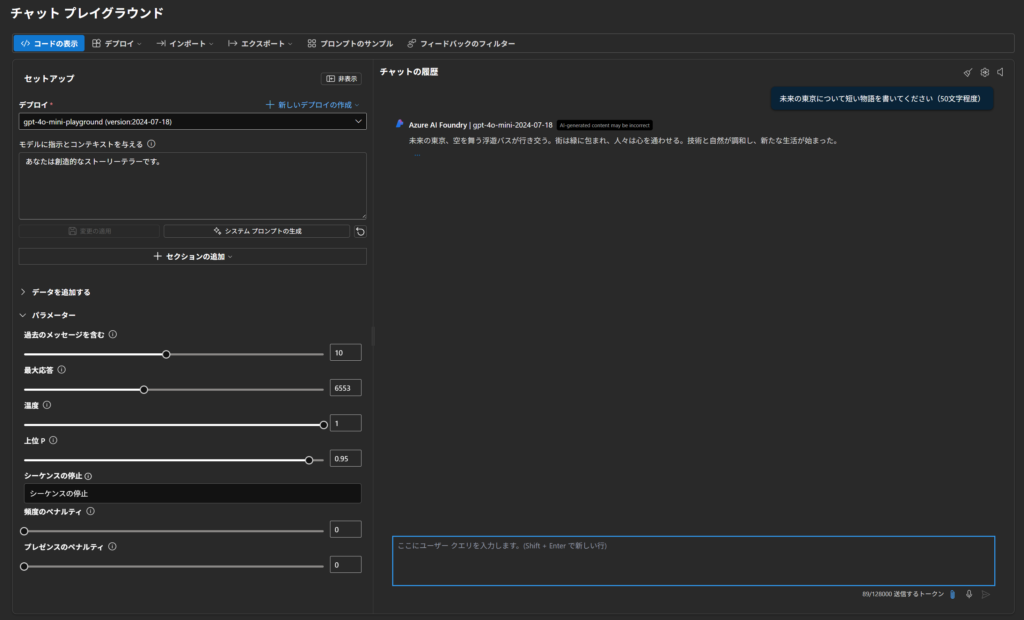

- 温度を 1.0 に変更

- 同じ質問を入力

- 返答をメモ

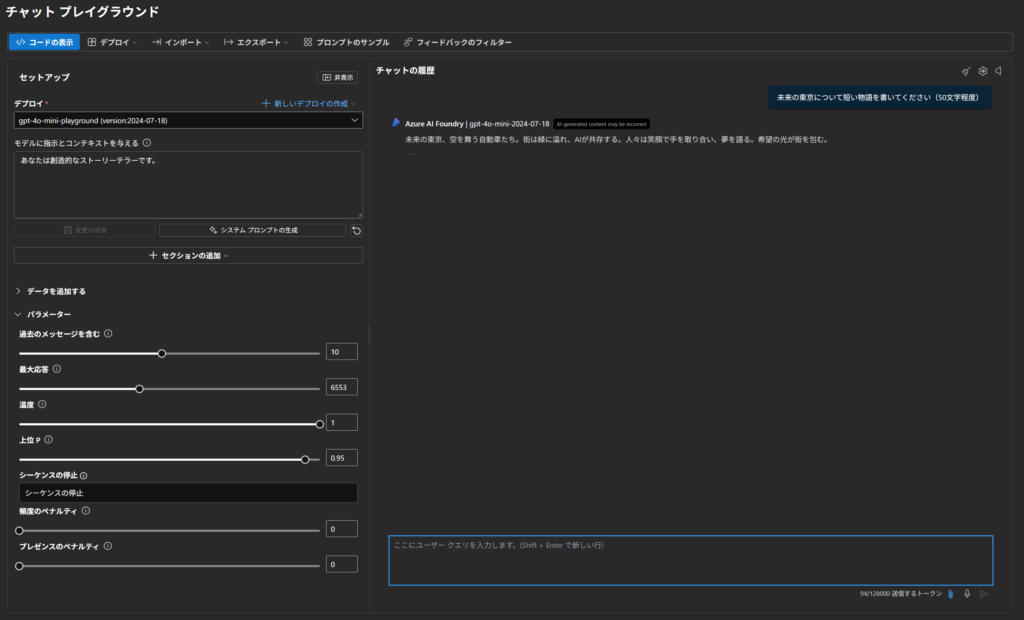

- チャットをクリア(温度 = 1.0のまま)

- もう一度同じ質問を入力(3回目)

結果

Temperature = 0.2:

未来の東京、空を舞うドローンが行き交う。人々はホログラムで会話し、緑豊かな屋上庭園で癒やされる。テクノロジーと自然が共存する街。

Temperature = 1.0(1回目):

未来の東京、空を舞う浮遊バスが行き交う。街は緑に包まれ、人々は心を通わせる。技術と自然が調和し、新たな生活が始まった。

Temperature = 1.0(2回目):

未来の東京、空を舞う自動車たち。街は緑に溢れ、AIが共存する。人々は笑顔で手を取り合い、夢を語る。希望の光が街を包む。

観察結果

- Temperature = 0.2: 比較的落ち着いた、予測可能な表現

- Temperature = 1.0(1回目と2回目): 内容が大きく異なっている

- どちらが創造的?: 明らかに1.0の方

Temperatureが高いと、同じ質問でも毎回違う答えが返ってくるんです。

(ブレインストーミングには1.0、正確な回答が欲しい時は0.2〜0.5がおすすめです!)

重要な注意点:

⚠️ Temperatureの範囲は 0〜1 です。

1以上には設定できません。

(私は最初1.5とか試そうとして、スライダーが動かなくて気づきました…笑)

トークンって何?

パラメーターの話をする前に、トークンについて簡単に説明しますね。

トークンは、AIが処理するテキストの最小単位です。

重要なポイント:

- トークン ≠ 文字数

- 日本語は1トークンで複数文字を表すことが多い

- 英語だと「1トークン ≒ 4文字」が目安

例えば、「最大応答 = 50トークン」と設定しても、日本語なら145文字くらい出力されます。

(この辺の感覚は、使いながら掴んでいくのが一番です!)

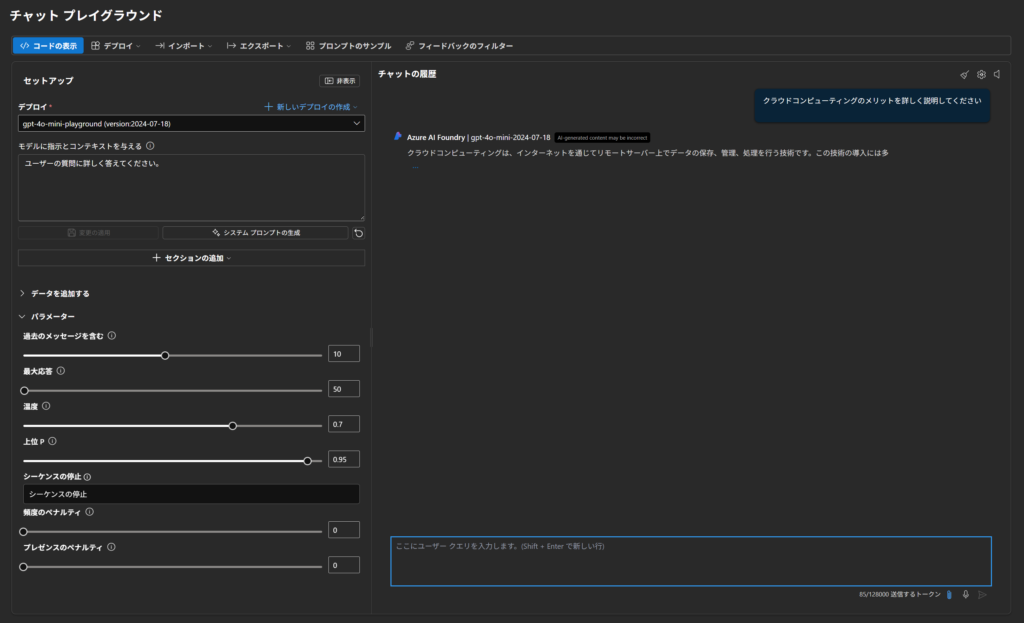

実験4: 最大応答(Max tokens)の制限

次は、最大応答パラメーターを試してみましょう。

これは、AIの返答の長さを制限するパラメーターです。

手順

- System message:

ユーザーの質問に詳しく答えてください。- 温度 = 0.7(中間値)

- 最大応答 を 50 に設定

- 質問:

クラウドコンピューティングのメリットを詳しく説明してください- 返答を確認

- チャットをクリア

- 最大応答 = 500 に変更

- 同じ質問

結果

最大応答 = 50:

クラウドコンピューティングは、インターネットを通じてリモートサーバー上でデータの保存、管理、処理を行う技術です。この技術の導入には多

- 途中で切れた? Yes(50トークンでも文として完結)

- 文字数: 66文字

最大応答 = 500:

クラウドコンピューティングは、インターネットを通じてリモートサーバーでデータを保存、管理、処理するサービスです。これにより、企業や個人は多くのメリットを享受できます。以下に、主なメリットを詳しく説明します。

1. コスト効率

初期投資の削減: クラウドサービスを利用することで、自社でサーバーやハードウェアを購入する必要がなく、初期投資を大幅に削減できます。

従量課金制: 使用した分だけ支払うモデルが多く、必要なリソースに応じてコストを抑えられます。これにより、無駄な支出を避けることができます。2. スケーラビリティ…(以下略)

- 文章になった? Yes

- 文字数: 650文字

最大応答を制限することで、簡潔な回答を強制できます。

(長々と説明されたくない時に便利ですね!)

逆に、詳しい説明が欲しい時は値を大きくすればOKです。

会話履歴の管理

次は、会話履歴について実験してみましょう。

AIは、同じチャットセッション内の過去の会話を覚えています。

でも、「チャットをクリア」をクリックすると、すべて忘れてしまいます。

実験5: 会話履歴のテスト

実際に確認してみましょう。

手順

- System message: 空、またはシンプルに「親切なアシスタント」

- パラメーター: デフォルトに戻す

- 以下の連続した会話を実施:

質問1:

私の名前は太郎です。覚えておいてください。質問2(チャットをクリアせずに続けて):

私の名前は何でしたか?質問3:

太郎という名前の由来を教えてください- ここで「チャットをクリア」をクリック

- もう一度質問:

私の名前は何でしたか?結果

- 質問2の返答: ✅ 名前を覚えていた

- 質問3の返答: ✅ 文脈を理解していた

- チャットをクリア後: ✅ 名前を忘れた

会話履歴がAIの応答に大きく影響することが確認できました。

実務での活用ポイント

会話履歴を活用する場合:

- 長い議論や相談

- 段階的な質問

- 前回の回答を踏まえた深堀り

チャットをクリアすべき場合:

- 全く別のトピックに切り替える時

- System Messageを変更した時

- 同じ質問で異なる回答パターンを試す時

(これ、意外と重要なポイントなんですよね!)

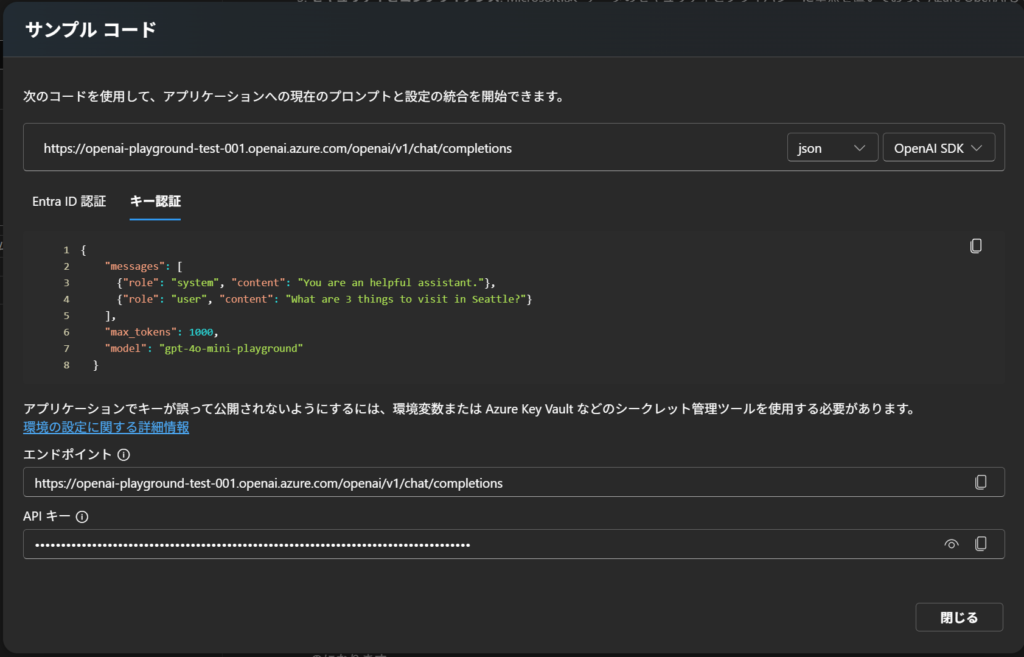

「コードの表示」機能

最後に、便利な機能を紹介します。

画面上部に「コードの表示」というボタンがあるのに気づきましたか?

何ができるの?

このボタンをクリックすると、現在の設定をコードで表示してくれるんです。

つまり、Playgroundで試した内容を、そのままプログラムに落とし込めるわけです!

(次回以降の記事で、このコードを使った実装を解説する予定です!)

実際に確認してみる

- 任意のSystem messageとParametersを設定

- 1-2回会話を実施

- 画面上部の「コードの表示」ボタンをクリック

- コードサンプルが表示されます

表示される内容

- エンドポイント: あなたのAzure OpenAIリソースのURL

- JSONコード: APIリクエストの形式

- OpenAI SDK: PythonなどのSDKでの実装例

重要なのは、System messageやParametersがすべてコードに含まれていること。

Playgroundで試行錯誤した設定を、そのままコピーして使えるんです。

(これ、めちゃくちゃ便利ですよね!)

⚠️ セキュリティの注意点:

コードにはAPIキーやエンドポイントが含まれています。

本番環境では、環境変数やAzure Key Vaultなどで管理してくださいね。

よくあるエラーと対処法

実際に使っていると、いくつかエラーに遭遇することがあります。

代表的なものをまとめておきますね。

エラー1: 「Quota超過」

症状:

ResourceQuotaExceeded: The deployment exceeds the quota...原因:

サブスクリプションタイプによるTPM(Tokens Per Minute)制限

解決策:

無料トライアル/Azure Passの場合:

- 従量課金サブスクリプションにアップグレードしてください

(無料トライアル/Azure PassではQuotaが0 TPMなので、一切使用できません)

Pay-as-you-go/MSDNでQuota不足の場合:

- 別のリージョンで試す(East US → Sweden Central等)

- gpt-4o-miniに変更する(Quotaが緩い)

- Quota増加フォームから申請

(有料サブスクリプションでも、初期Quotaが不足する場合があります…)

エラー2: 初回応答が遅い

症状:

最初の質問だけ、返答に20-40秒かかる

原因:

Cold Start – デプロイ直後の初期化処理

解決策:

これは正常動作です!

2回目以降は3-5秒程度に高速化します。

(焦らず待ちましょう!)

エラー3: System Messageが反映されない

症状:

System Messageで「丁寧な敬語で」と指示したのに、フランクな口調で返ってくる

原因:

- 指示が曖昧

- モデルの基本動作と矛盾

解決策:

より具体的で明確な指示に修正してください。

悪い例:

丁寧に話してください良い例:

すべての返答は「です・ます」調で、

敬語を使って丁寧に回答してください。

カジュアルな表現や省略形は使用しないでください。(具体的に書くのがコツです!)

エラー4: デプロイ一覧に表示されない

症状:

モデルをデプロイしたはずなのに、Playground のデプロイ選択に表示されない

原因:

- デプロイが完了していない

- 別のリソースを見ている

解決策:

- デプロイ一覧でステータスが「成功」になっているか確認

- 画面左上で正しいリソースが選択されているか確認

- ページをリフレッシュ

まとめ

はい、いかがでしたでしょうか?

今回は、Azure AI Foundry Playgroundを使ったAzure OpenAIの実践的な使い方を解説しました!

実現できたこと:

- ✅ ブラウザだけでAzure OpenAIを体験

- ✅ System Messageでカスタマイズ

- ✅ パラメーター調整で出力を制御

- ✅ 会話履歴の管理方法を理解

- ✅ よくあるエラーの対処法を習得

次のステップ:

- 「コードの表示」機能で取得したコードを使った実装

- APIを使った本格的なアプリケーション開発

- RAGを使った独自データの活用

(次回以降の記事で順番に解説していく予定です!)

プログラミング不要で、ここまでできちゃうんです。

Power Platform触ってる方なら、この感覚、分かりますよね!

(Playgroundで試して、うまくいったらコード化する、この流れが最強です)

とても便利なのでぜひ使ってみてください!

それでは皆さん、良い業務ハックライフを~

コメント